先日、マイクロソフトとアップルがPCやスマートフォンで動作するAIチップの開発でしのぎを削っているという新聞記事を目にしました。

この動向は、もちろん昨今のAI技術、特に画像認識や生成AIの進化をその背景としています。なぜクラウドでは無く、敢えてスマホでAI処理を行うのでしょうか?

画像認識や生成AIの普及が進むと大量の推論処理が発生し、クラウド側の負担が過大となるからです。推論処理をスマホへオフロードする事で、結果を得る時間が短縮できますし、インターネットへ流れる通信トラフィックも削減できます。非常に合理的だと感じる一方で、私はハードウェアに再び世間の注目が集まっていることに時代の変化を感じました。

グラフィクス処理LSI(GPU)の最大手であるNVIDIAの業績が米国株価へ影響を及ぼすことがまさにその象徴と言えるでしょう。

AI処理を従来のCPUを用いてソフトウェアで実行しようとすると大変な計算時間を要してしまいます。AI処理が必要とするハードウェアは、単純な演算を並列で大量に行うことを特徴としています。このような処理はCPUはあまり得意ではないのです。

一方、GPUはそのような処理こそが得意です。GPU分野の雄であったNVIDIAが高速AI処理を行うためのハードウェアベンダーとして一躍脚光を浴び、今やGAFAMと肩を並べるほどの企業となった理由はそこです。

NPUの実装によってスマホのバッテリー消費は増大する

スマホで動作するAIチップとは、換言するとAI処理のために作られた専用のGPU的ロジック回路を意味します。

そもそも、スマホに搭載されたGPUは、文字通りの本来の役目、すなわちスマホの画面に表示される様々な映像や動画の処理のために使われますから、このロジック回路は、GPUと区別して、NPU(Neural Processing Unit)と呼ばれています。

スマホで求められるAI処理とは、学習処理ではなく、学習された推論モデルを使って入力データから結果を推論する処理であろうと思います。

AIの進化・多様化に伴って、スマホやPCに搭載されるNPUの規模は年々大きくなっていくと予想されます。ただでさえ忙しく数多くの処理を行わねばならないスマホにNPUの実装は大きな負担となっていくでしょう。

特に問題となるのが電力消費量の増大です。

スマホの「バッテリー残量」は、「残りのギガ」以上に多くの人がいつも気にしている鬱陶しい存在なのではないでしょうか?電力を大量に消費するNPUの実装によってその心配はさらに深刻になってしまうことが予想されます。

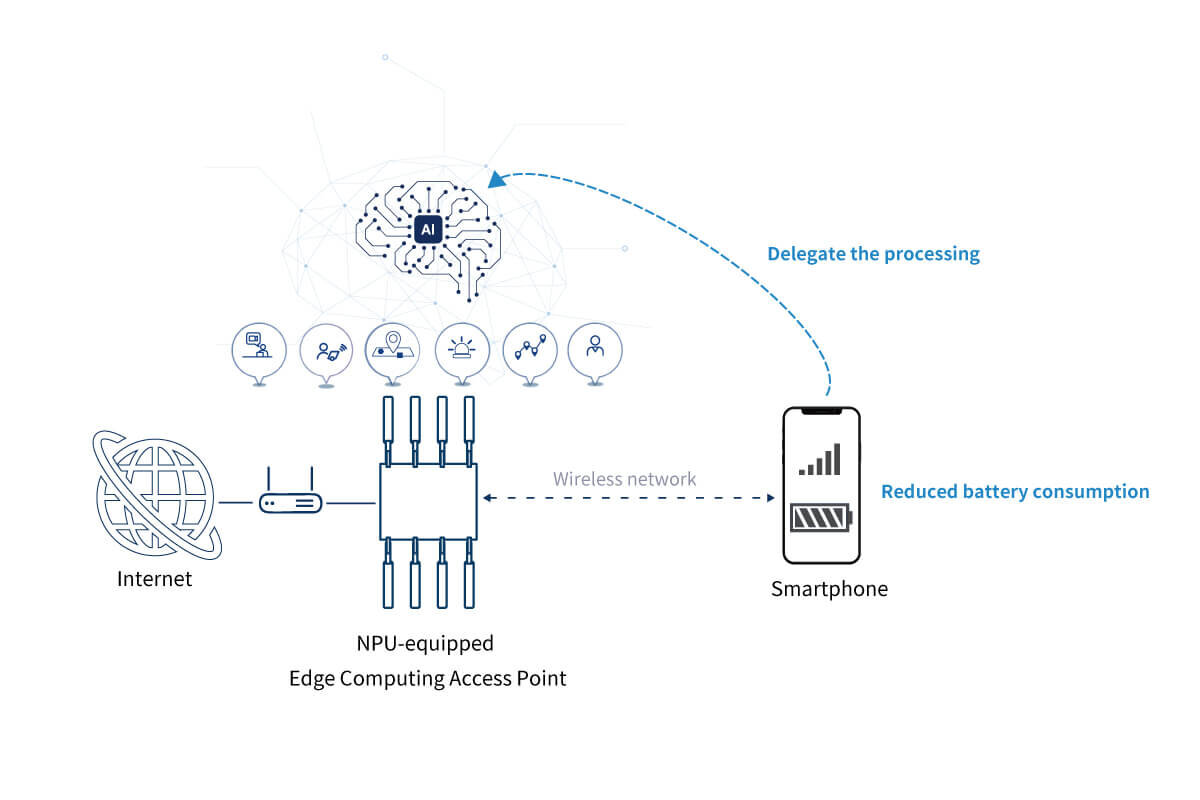

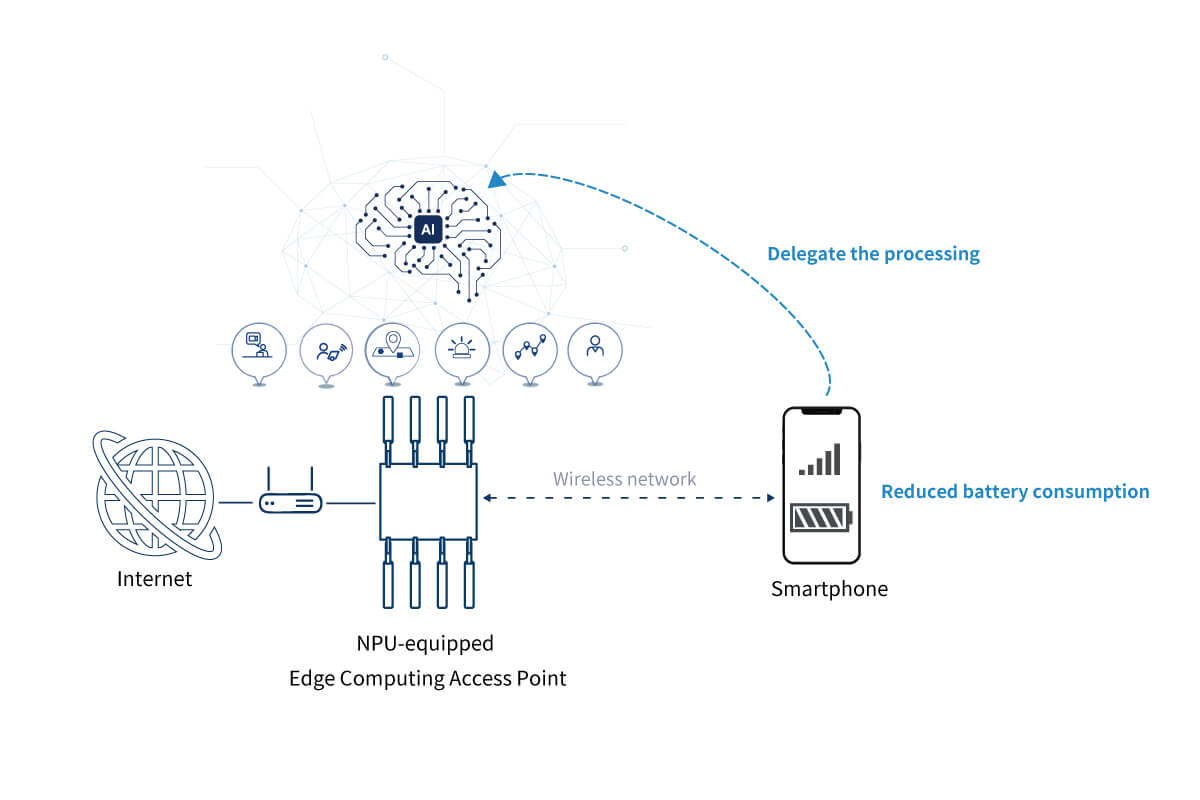

Wi-FiのアクセスポイントにAI処理を肩代わりさせることで、スマホのバッテリー消費を軽減

そこで、Wi-Fiのアクセスポイント、つまりスマホに最も近い情報通信インフラにNPUを搭載し、スマホに代わってAI処理を行わせるという発想はどうでしょう?

これによって、スマホは電力消費量の大きいNPUを実装する必要がなくなります。

Wi-Fiアクセスポイントは通常はAC電源に接続されていますので、バッテリー残量を気にする必要はありません。また、Wi-Fiアクセスポイントはスマホから見てインターネットへの接続点より手前に設置されますので、リアルタイム性が要求されるAI処理であっても、インターネットを介さずに即座に結果を得ることができます。

当社が目指すエッジコンピューティングで実現したい価値の一つは、「スマホのバッテリーの持ちを良くする」ことです。NPUが搭載されたメッシュWi-Fiエッジコンピュータを導入すれば、スマホのバッテリー消費が抑制される・・・このような価値の提供はエッジコンピューティングプラットフォーマーが担っていく重要な役目になるだろうと考えています。

著者

PicoCELA株式会社

代表取締役社長 古川 浩

NEC、九州大学教授を経て現職。九大在職中にPicoCELAを創業。

一貫して無線通信システムの研究開発ならびに事業化に従事。工学博士。